Prompt injection indiretta, Google la sua strategia di sicurezza a più livelli

Giu 24, 2025 Marina Londei

Hacking, In evidenza, Minacce, News, RSS, Tecnologia

0

Tra le minacce più preoccupanti per i sistemi di intelligenza artificiale c’è la prompt injection indiretta, una tecnica che, a differenza di quella diretta, nasconde istruzioni malevole in sorgenti esterne, come inviti a riunioni, email o documenti. Per proteggersi da questa modalità di prompt injection, Google sta integrando nuove misure di sicurezza a più livelli nei propri strumenti.

La strategia “stratificata” del gigante tech prevede misure di sicurezza a ogni livello del ciclo di vita del prompt per rendere più difficile il lavoro dell’attaccante, in modo che “siano costretti ad affidarsi a metodi più facili da individuare o che richiedono più risorse“.

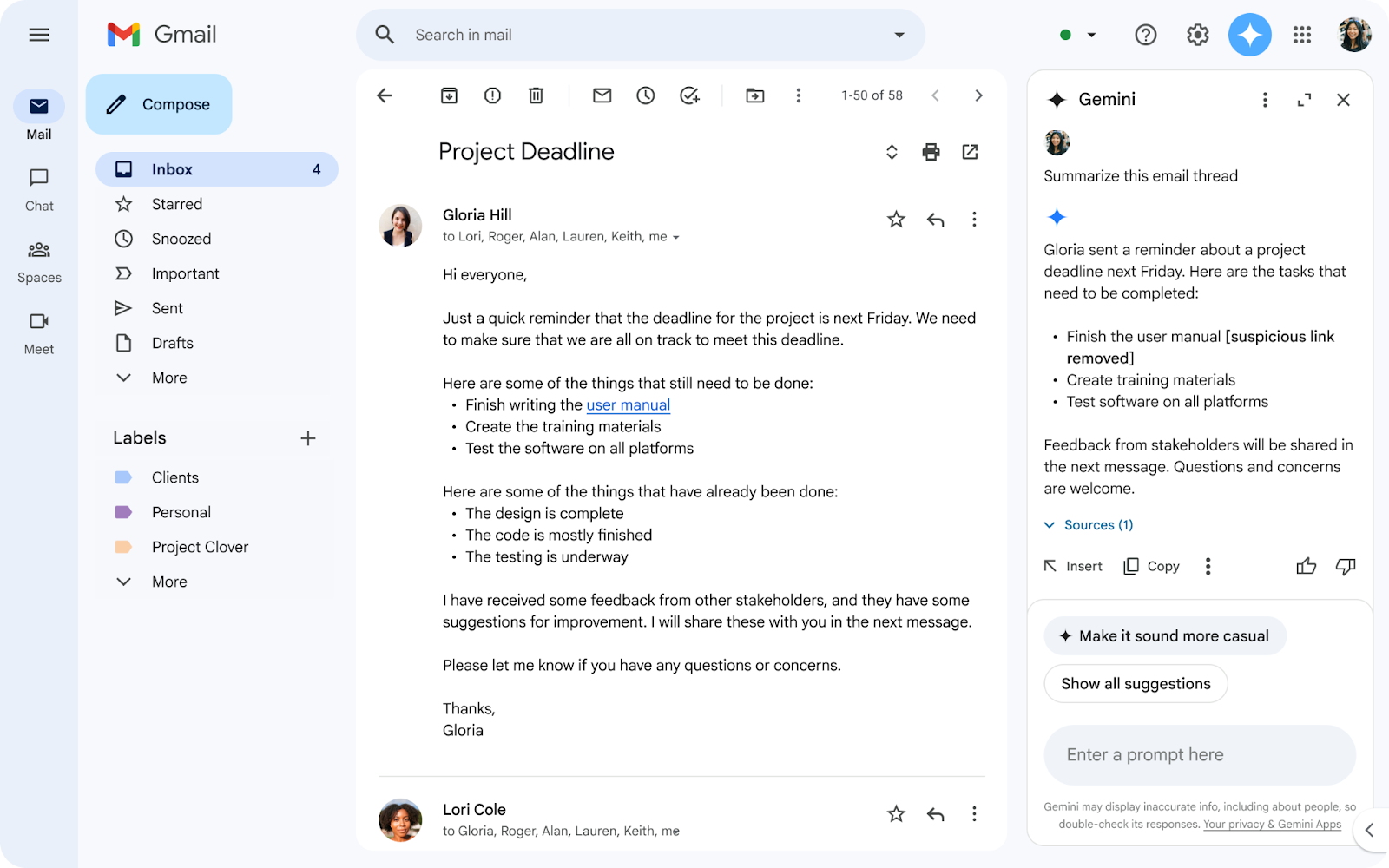

La difesa di Google contro l’iniezione indiretta di comandi comincia proprio dal prompt: la compagnia sta rilasciando dei modelli di machine learning in grado di individuare prompt e istruzioni malevole in diverse forme, comprese email e file. “Quando gli utenti cercano dati su Workspace con Gemini, i classificatori di contenuti filtrano i dati pericolosi che contengono istruzioni malevole“.

Il secondo livello di protezione prevede un ulteriore controllo sul prompt che obbliga l’LLM a eseguire esclusivamente l’istruzione richiesta dall’utente, ignorando qualsiasi altra istruzione che potrebbe essere presente nel contenuto da caricare.

Il terzo livello di protezione agisce sugli URL delle immagini esterne, impedendo all’LLM di renderizzarle, e segnala qualsiasi URL sospetto senza includerlo nella risposta.

Credits: Google

Dal prossimo futuro Gemini richiederà, come ulteriore misura di protezione, un sistema di conferma utente per eseguire determinate azioni; “Per esempio, operazioni potenzialmente rischiose come cancellare un evento dal calendario scatenerebbe una richiesta di conferma per l’utente, aiutando così a prevenire l’esecuzione immediata e nascosta dell’operazione“.

Infine, come ultima misura di sicurezza contro la prompt injection indiretta, Gemini notificherà all’utente l’eventuale presenza di allegati e contenuti malevoli, cancellando la risposta generata.

“La nostra strategia di sicurezza completa contro la prompt injection rafforza l’intero framework di sicurezza per Gemini“ ha affermato il team di Google. Oltre alle tecniche integrate nell’LLM, la compagnia ha annunciato nuovi test manuali e automatici di red teaming, l’uso di robusti standard di sicurezza come il Secure AI Framework (SAIF) e nuove partnership sia con ricercatori tramite il programma VRP (Vulnerability Reward Program) che con altre aziende tech grazie alla Coalition for Secure AI (CoSAI).

Altro in questa categoria